티스토리 뷰

이번 발표의 핵심은 AWS가 NVIDIA의 GH200 Grace Hopper Superchips를 제공하는 최초의 주요 클라우드 제공업체가 되었다는 것입니다.

re:Invent 2023에서 AWS CEO Adam Selipsky와 NVIDIA CEO Jensen Huang은 클라우드 혁신에서 생성 AI의 중추적인 역할을 강조했습니다. 그들은 전 세계 기업에 최신 혁신을 제공하고 고객 성공을 지원하기 위해 회사의 파트너십 확대에 주목했습니다.

AI와 클라우드 컴퓨팅 전문 지식을 결합한 NVIDIA 창립자이자 CEO인 Jensen Huang은 화요일 Selipsky와 함께 무대에 올라 AWS-NVIDIA 협력 확장을 발표했습니다. 여기에는 차세대 애플리케이션을 촉진하기 위해 고급 그래픽, 기계 학습 및 생성 AI 인프라를 제공하는 더 많은 제품이 포함됩니다.

이번 발표의 핵심은 AWS가 NVIDIA의 GH200 Grace Hopper Superchips를 제공하는 최초의 주요 클라우드 제공업체가 되었다는 것입니다. Huang이 설명했듯이 GH200은 고속 NVLink 상호 연결을 사용하여 NVIDIA의 새로운 Arm 기반 Grace CPU와 고급 Hopper GPU를 고유하게 연결합니다.

32개의 GH200 노드에 걸쳐 있는 NVL32 구성으로 함께 클러스터링되면 플랫폼은 슈퍼칩당 최대 4페타플롭의 놀라운 처리 능력을 제공합니다. 또한 테라바이트 규모의 메모리를 통해 최신 AI 워크로드에 필요한 대규모 데이터 세트를 처리할 수 있습니다.

고객은 EFA(Elastic Fabric Adapter) 네트워킹, Nitro 하이퍼바이저 및 EC2 UltraClusters와 같은 다른 AWS 혁신을 활용하여 수천 개의 GH200 칩을 AI에 특화된 유연한 클라우드 기반 슈퍼컴퓨터에 상호 연결할 수 있습니다.

협업의 일환으로 AWS는 NVIDIA DGX Cloud를 호스팅하여 DGX를 관리형 서비스로 제공할 예정입니다. DGX Cloud는 인프라 관리 부담을 없애 개발자가 모델 훈련에 집중할 수 있도록 해줍니다.

AWS의 DGX Cloud 인스턴스는 GH200 NVL32 구성을 최초로 제공합니다. 이는 1조 개의 매개변수를 초과하는 차세대 모델에 대한 훈련을 가속화하는 데 도움이 될 것입니다.

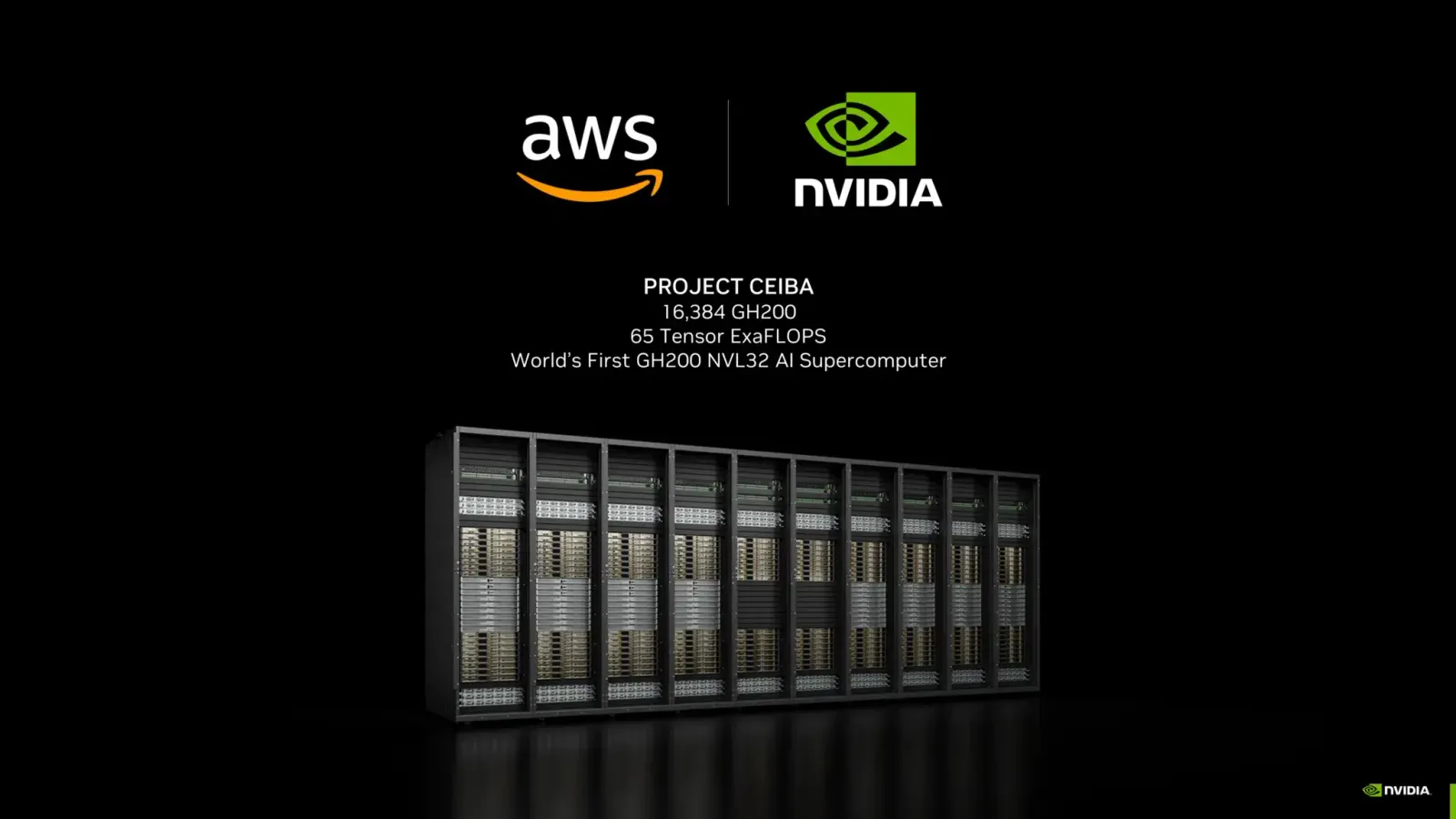

아마도 가장 야심찬 프로젝트에서 AWS와 NVIDIA는 'Project Ceiba'에서 협력하여 세계에서 가장 빠른 GPU 기반 AI 슈퍼컴퓨터를 구축하고 있습니다.

장엄한 아마존 세이바(Amazonian Ceiba) 나무의 이름을 딴 프로젝트 세이바(Project Ceiba)는 AWS의 EFA 네트워킹을 사용하여 상호 연결된 16,384개 이상의 NVIDIA GH200 노드로 구성됩니다. NVIDIA는 자체 AI 연구 및 개발에 65엑사플롭 슈퍼컴퓨터를 사용할 계획입니다.

Huang이 강조한 것처럼 NVIDIA는 디지털 그래픽, 로봇 공학, 기후 과학, 신약 발견 등을 포괄하는 광범위한 AI 연구에 Project Ceiba를 활용할 것입니다. 극단적인 규모는 생성적 AI 접근 방식에서 획기적인 혁신을 가능하게 할 것입니다.

또한 파트너는 더 광범위한 고객이 최첨단 AI 하드웨어에 쉽게 액세스할 수 있도록 Amazon EC2 인스턴스를 도입하고 있습니다.

- 대규모 생성 모델 및 HPC 워크로드를 위해 NVIDIA의 최신 H200 GPU를 활용하는 P5e 인스턴스

- 보다 저렴한 AI 훈련/추론을 위해 새로운 NVIDIA L4 및 L40S GPU를 갖춘 G6/G6e 인스턴스

AWS와 NVIDIA는 AI 인프라, 소프트웨어 라이브러리, 기반 모델과 같은 영역의 새로운 하드웨어와 서비스를 통해 생성적 AI 채택의 다음 단계를 공동으로 추진하는 것을 목표로 하고 있습니다.

'AI 생태계' 카테고리의 다른 글

| Microsoft의 Copilot은 OpenAI의 최신 모델과 새로운 코드 해석기를 제공합니다. (0) | 2023.12.06 |

|---|---|

| Amazon, 텍스트를 이미지로 변환하는 모델인 Titan Image Generator 출시 (0) | 2023.12.05 |

| 볼티지 파크(Voltage Park), AI 개발을 위한 대규모 새 클라우드 출시 (0) | 2023.12.01 |

| Animatable Gaussians - 인간 아바타를 생성하는 새로운 기술 (0) | 2023.11.30 |

| Generative AI와의 대화에서 프롬프트 구조 (0) | 2023.11.28 |